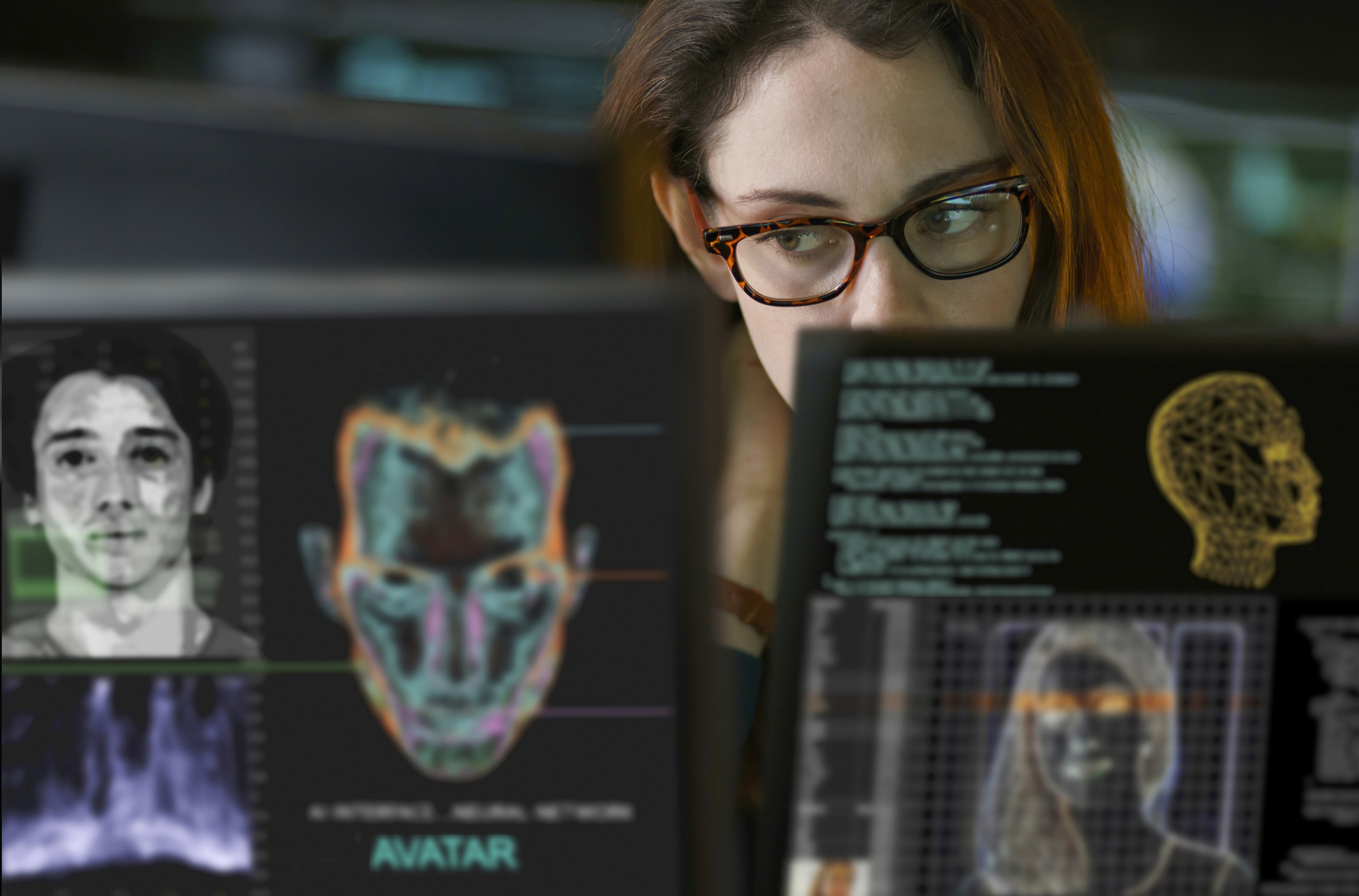

Мошенники активно используют дипфейки — сгенерированные ИИ видео, на которых злоумышленники маскируются под знакомых жертвам людей или других доверенных лиц, включая чиновников. RT узнал у экспертов, как можно распознать дипфейки: какие признаки укажут на сомнительное происхождение материалов, на что стоит обратить внимание при самостоятельном просмотре и в каких случаях проверить видео на достоверность помогут специальные программы и приложения.

Мошенники разработали новую схему с использованием видеозаписей, сгенерированных нейросетями. Злоумышленники записывают на видео обращения, в которых рассказывают о неких выплатах или прибавках к заработной плате. Затем посредством ИИ они меняют голос и изображение — якобы обещания даёт кто-то из федеральных чиновников.

Видео, как сообщает ТАСС со ссылкой на МВД РФ, рассылаются по электронной почте. Потенциальным жертвам предлагается перейти по ссылке, также размещённой в письме. При нажатии на ссылку на телефон загружается вредоносное приложение.

Позже с жертвой по телефону связывается мошенник, который представляется финансовым консультантом. Аферист рассказывает о выплатах, предлагает поучаствовать в «заключении госконтракта», взять кредит, а также перевести деньги на специальный счёт.

RT узнал у экспертов, можно ли избежать обмана с применением дипфейков и какие технические средства могут в этом помочь.

— По каким признакам человек может понять, что перед ним сгенерированное изображение и видео?

Директор по безопасности компании «Кибердом» Антон Терешонков:

— Обратите внимание на активное движение век. В реальном видео человек моргает 15—20 раз в минуту. В дипфейках — мигание глаз либо полностью отсутствует длительное время, либо происходит механически и странным, неестественным образом.

Второе — синхронизация губ и звука. Даже в качественных подделках есть микрозадержки между движением рта и речью. Настоящее лицо движется комплексно (щёки, подбородок, мимика), а синтетическое изображение часто двигает только губами.

Третье — освещение и тени. Генерируемые видео плохо воспроизводят физику света. Тени от носа и ушей не совпадают с источником света. Блики на очках либо отсутствуют, либо статичны при повороте головы.

На границе лица и фона ищите размытость, дрожание краёв, когда качество лица не совпадает с окружением. Проверьте анатомию — пальцы, текстуру кожи (в подделках она часто слишком идеальная), волосы.

Аспирант факультета безопасности информационных технологий Университета ИТМО Виталий Роговой:

— На сгенерированном видео могут присутствовать фоновые артефакты, искажения частей лица. При полной генерации — если в кадре есть зеркало, там может появиться случайный человек. Отражения в зеркалах или очках могут не совпадать с окружением. Есть и другие физические несоответствия: жесты часто выглядят скованно. Голос может звучать роботизировано, без естественных пауз.

Генеральный директор Smart Engines, доктор технических наук Владимир Арлазаров:

— Технологии создания дипфейков постоянно совершенствуются, и обнаружить их невооружённым глазом становится всё сложнее. Когда подменяется только лицо, без специальной подготовки и покадрового анализа светотени, текстур и других нюансов человеку действительно очень трудно уверенно сказать, что перед ним дипфейк.

Поэтому на практике ключевую роль играет не намётанный глаз, а элементарная цифровая гигиена. К незнакомым звонкам, ссылкам и особенно срочным просьбам перевести деньги нужно относиться с максимальной настороженностью — даже если голос и лицо по ту сторону экрана выглядят абсолютно убедительно.

Специалист по кибербезопасности, президент консорциума «Инфорус» Андрей Масалович:

— Есть некоторые косвенные признаки, если фейк сделан халтурно: например, когда авторы не позаботились о так называемых метаданных в файле и видно, что видео снято не тогда и не там. Другое важное свойство фейков — их долго редактируют, и у файла различаются дата создания и дата редактирования. То есть это не фиксация события. Но эти данные доступны не всегда.

Эксперты оценили возможности представленного на днях личного робота-помощника с искусственным интеллектом. По заявлениям…

Получая сообщения в мессенджерах с незнакомых аккаунтов, стоит обратить внимание на то, когда и где создан этот аккаунт. Некоторые платформы пишут, что пользователь недавно сменил имя или фотографию. Если аккаунт «вещает» не из России, но представляется, например, московским, это тоже повод задуматься. От старательных злоумышленников такие меры не уберегут. Но надо проявлять бдительность. Во многих случаях это спасает.

Дипфейки распространяются по каким-либо каналам, пользователи пересылают их друг другу — поэтому не стоит злоупотреблять репостами, а тем более переходить по ссылкам. И надо чётко понимать, что, если предлагается что-то интересное, необычайно выгодное, это наверняка враньё.

Я поддерживаю идею введения маркировки изображений или видео, сделанных с использованием искусственного интеллекта. Тогда авторов дипфейков можно будет привлечь к уголовной ответственности.

— Какие есть IT-решения, которые помогают автоматически выявлять ИИ-видео? Насколько они эффективны и можно ли блокировать дипфейки программными средствами?

А. Т.: Существуют решения, которые автоматически проверяют видео с точностью до 97—99%: российские VisionLabs, MTС Web Services, зарубежное Sensity AI. Для простого пользователя есть такие онлайн-сервисы, как Undetectable AI, Hugging Face Deepfake Detector, но они требуют ручной загрузки файла.

Пока нет готового приложения для смартфона, которое автоматически блокирует все дипфейки в мессенджерах, так как генеративные модели постоянно совершенствуются и опережают системы обнаружения.

В. А.: Полностью оградить себя от вредоносного контента сегодня вряд ли возможно, однако решения для надёжного обнаружения дипфейков уже разработаны. Наиболее эффективные технологии детекции работают на крупных платформах — в банковских приложениях, государственных сервисах, системах онбординга и KYC. Такие системы выявляют следы цифрового вмешательства в фотографии и видео. Речь о подмене лица, сгенерированных бланках документов, склейке изображений селфи и паспорта из разных источников, об изменении отдельных реквизитов в документе (Ф. И. О., даты, номера), о «пересъёмке» с экрана или распечатки вместо оригинала.

ИИ анализирует согласованность элементов в кадре, лица с фотографией из документа и метаданные файла, а затем по совокупности признаков решает, имеет ли место вмешательство. Именно такие системы становятся последней линией защиты в сценариях, когда злоумышленники пытаются оформить кредит или получить доступ к чужому аккаунту с помощью сгенерированных селфи и поддельных документов.

Биометрия становится неотъемлемой частью повседневной реальности: скоро можно будет подтверждать возраст при покупке табака и алкоголя…

А. М.: Есть много приложений, которые выявляют некоторые свойства, характерные для фейка, например удалённые или нереалистичные метаданные. Существуют и довольно чёткие алгоритмы, которые могут выделить отредактированные части изображения или видео. Это научный подход, и он работает.

Но до обычных пользователей такие технологии пока что не дошли — и программ, которые однозначно могли бы определить фейк, сейчас не существует.

В. Р.: На текущий момент готовые решения работают скорее с аутентификацией пользователей при входе в какую-либо систему по биометрии, например на «Госуслуги». Работа с дипфейками сопряжена с огромным количеством трудностей. Так, фотографии, сделанные на iPhone, улучшаются собственными алгоритмами повышения качества изображений — и эти изображения тоже можно считать изменёнными. Таким образом, возможно большое количество ложных срабатываний.

— Есть ли техническая возможность встроить в алгоритмы мессенджеров, где чаще всего действуют преступники, системы предупреждения пользователей о дипфейках?

А. Т.: Технически это возможно, но есть препятствия. Анализ каждого видео требует больших вычислительных ресурсов и замедляет доставку сообщений. В мессенджерах с шифрованием end-to-end (WhatsApp*, Telegram) платформа не может видеть контент без нарушения приватности. Корпоративные системы уже используют встроенные детекторы. Для публичных платформ лучшая защита пока что — организационная: двухфакторная аутентификация, проверка личности через альтернативные каналы, постоянное обучение сотрудников.

В. А.: Мессенджеры могут встроить детекторы дипфейков либо на стороне серверов, анализируя загружаемые медиа до доставки адресату, либо частично на устройстве пользователя, запуская модели прямо в приложении. По сути, это те же алгоритмы, которые уже применяются банками и другими организациями для анализа изображений и видео.

Широкому внедрению таких решений могут препятствовать вопросы конфиденциальности, вычислительные затраты и риск ложных срабатываний, когда настоящее видео будет ошибочно помечено как фейк. Но с точки зрения технологий встроенные системы предупреждения о дипфейках в мессенджерах — вполне реализуемый сценарий.

В. Р.: Встроенные системы проверки в мессенджерах — это реализуемо. Но они сталкиваются с общей проблемой: если изображения обработаны в обычных программах для улучшения качества, это всё равно будет считаться искажением.

А. М.: Разработчики помечают, если аккаунт действует из другой страны или в нём используется подменный номер телефона, недавно сменилась фотография или имя. Маркируют файлы, которые часто пересылают, чтобы человек знал, что этот файл получил не только он. Это уже повод для беспокойства.

Сейчас все наперебой обещают создать нейросеть, которая станет спасением. Но уже подсчитано, что у 95% бизнес-проектов, внедряемых нейросетями, это не получается. Таким образом, до реального «промышленного» применения подобных средств пока дело не доходит.

* Продукт Meta, деятельность признана экстремистской, запрещена на территории России по решению Тверского суда Москвы от 21.03.2022.